انتخاب تابع فعالسازی به نوع شبکه عصبی شما و نوع دادهای که روی آن آموزش میدهید بستگی دارد. در اینجا برخی از رایجترین توابع فعالسازی و مزایا و معایب آنها آورده شده است:

-

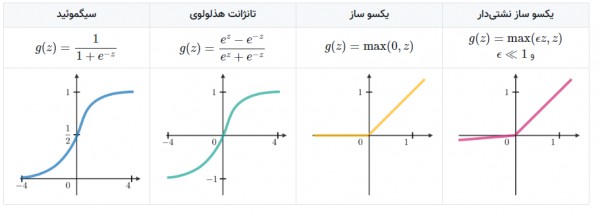

تابع سیگموید یک تابع غیرخطی است که معمولاً در لایههای خروجی شبکههای عصبی طبقهبندیکننده استفاده میشود. این تابع یک مقدار بین 0 و 1 تولید میکند که میتوان از آن برای تخمین احتمال یک نمونه به عنوان عضو هر کلاس استفاده کرد. مزایای تابع سیگموید عبارتند از:

-

آسان برای محاسبه

-

آسان برای تفسیر

-

طیف وسیعی از مقادیر خروجی

معایب تابع سیگموید عبارتند از: * میتواند در مسائل با تعداد زیادی کلاس کند باشد * میتواند در مسائل با دادههای نامتوازن ناپایدار باشد

-

تابع تانژانت هایپربولیک یک تابع غیرخطی است که معمولاً در لایههای پنهان شبکههای عصبی استفاده میشود. این تابع یک مقدار بین -1 و 1 تولید میکند که میتوان از آن برای مدلسازی روابط پیچیده بین ورودیها و خروجیها استفاده کرد. مزایای تابع تانژانت هایپربولیک عبارتند از:

-

آسان برای محاسبه

-

آسان برای تفسیر

-

طیف وسیعی از مقادیر خروجی

معایب تابع تانژانت هایپربولیک عبارتند از: * میتواند در مسائل با تعداد زیادی کلاس کند باشد * میتواند در مسائل با دادههای نامتوازن ناپایدار باشد

-

تابع ReLU یک تابع غیرخطی است که اخیراً محبوبیت زیادی پیدا کرده است. این تابع بسیار کارآمد و پایدار است و میتواند در مسائل با تعداد زیادی کلاس و دادههای نامتوازن استفاده شود. مزایای تابع ReLU عبارتند از:

-

بسیار کارآمد

-

بسیار پایدار

-

میتوان از آن در مسائل با تعداد زیادی کلاس و دادههای نامتوازن استفاده کرد

معایب تابع ReLU عبارتند از: * میتواند در مسائل با دادههای منفی ناپایدار باشد * ممکن است در مسائل با دادههای غیرخطی به خوبی عمل نکند

-

تابع Leaky ReLU یک نوع از تابع ReLU است که برای حل مشکل ناپایداری دادههای منفی طراحی شده است. این تابع مقدار 0 را برای ورودیهای منفی و شیب کوچکی را برای ورودیهای مثبت تولید میکند. مزایای تابع Leaky ReLU عبارتند از:

-

پایدارتر از تابع ReLU

-

میتوان از آن در مسائل با دادههای منفی استفاده کرد

معایب تابع Leaky ReLU عبارتند از: * ممکن است به خوبی تابع ReLU در مسائل با دادههای غیرخطی عمل نکند

انتخاب تابع فعالسازی به نوع شبکه عصبی شما و نوع دادهای که روی آن آموزش میدهید بستگی دارد. هیچ پاسخ صحیح یا غلطی وجود ندارد، بنابراین بهتر است چند مورد را امتحان کنید تا ببینید بهترین عملکرد را برای شما دارد.